Was ist Crawling?

Was macht ein Crawler?

Crawler (auch Spider oder Bots genannt) ‘krabbeln’ über Websites und sammeln Daten. Über interne und externe Verlinkungen arbeiten sie sich Seite für Seite vor. Welche Daten sie sammeln, hängt von Zweck und Urheber der Crawler ab.

Crawler (auch Spider oder Bots genannt) ‘krabbeln’ über Websites und sammeln Daten. Über interne und externe Verlinkungen arbeiten sie sich Seite für Seite vor. Welche Daten sie sammeln, hängt von Zweck und Urheber der Crawler ab.

Verwendet werden Crawler vor allem durch Suchmaschinen. Aber auch durch Analyse-Softwares, mit der du deine Website untersuchen kannst, nutzen Crawler. Das sind beispielsweise SEO-Tools.

Es gibt aber auch Crawler bzw. Bots, die gezielt persönliche Daten einer Website sammeln. Oft werden hier E-Mail-Adressen und andere sensible Daten gespeichert, um sie später ohne Wissen und Zustimmung der Besitzer weiter zu verwenden. Die Folge sind beispielsweise Spam-Mails.

Crawler haben nicht automatisch Zugang zu allen Bereiche deiner Website. Du hast zwei Möglichkeiten, das Verhalten der Crawler auf deiner Website zu steuern:

- Mit der robots.txt-Datei verfasst du eine Art Leitfaden für die Bots. Es definiert, welche Bereiche oder Seiten die crawlen sollen, und welche nicht. Die robots.txt ist allerdings nur ein Leitfaden, kein Regelwerk. Die meisten Crawler halten sich allerdings daran.

- Um Spider mit missbräuchlichen Absichten effektiv aus bestimmten Bereichen und Inhalten auszusperren, setzt du die .htaccess-Datei ein.

![]() Wir haben für dich einen ausführlichen Artikel erstellt, wie du die robots.txt richtig einsetzt und die Crawler gezielt steuerst.

Wir haben für dich einen ausführlichen Artikel erstellt, wie du die robots.txt richtig einsetzt und die Crawler gezielt steuerst.

Wir beschäftigen uns jetzt näher mit dem Crawling durch die Suchmaschinen-Bots von Google, Bing und Co.

Crawling durch Suchmaschinen

Beim Crawling erfasst der Googlebot (oder andere Suchmaschinen-Crawler) deine Website — sofern durch die robots.txt nicht anders definiert. Dabei versuchen sie, den Aufbau (Struktur und Schwerpunkte) sowie die Inhalte deiner Website zu verstehen. Darüber hinaus registrieren sie den technischen Zustand der Seite.

Später nutzen Suchmaschinen nutzen die gesammelten Informationen dafür,

- diese Inhalte zu indexieren (gemäß der Indexing-Angaben der einzelnen Seiten)

- die Relevanz zu diversen Suchanfragen zu ermitteln (Ranking).

Das Crawling der Inhalte ist also die Voraussetzung für die Indexierung und das Ranking zu passenden Suchbegriffen.

So erfassen Suchmaschinen deine Website:

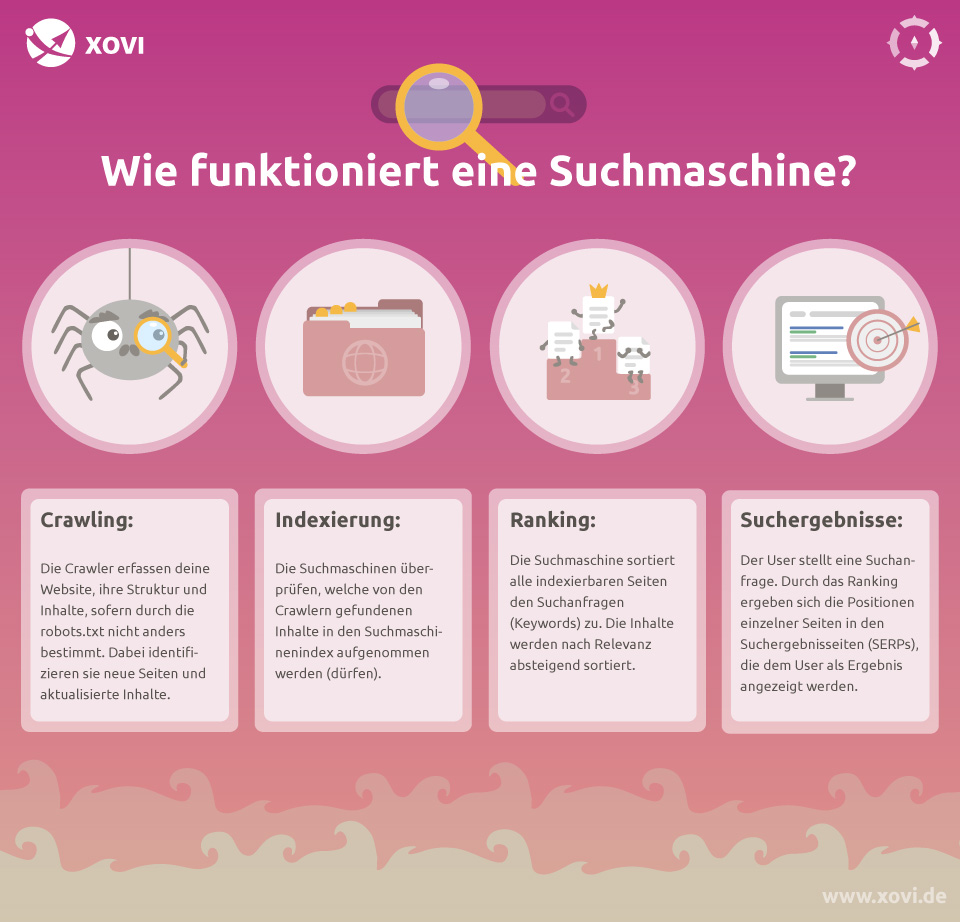

Crawling:

Die Crawler “krabbeln” über deine deine Website. Dabei erfassen sie ihre Struktur und Inhalte, sofern durch die robots.txt nicht anders bestimmt. Dabei können Crawler erkennen, ob seit dem letzten Crawl neue Inhalte hinzugekommen sind oder bestehende Inhalte aktualisiert wurden.

Die Crawler “krabbeln” über deine deine Website. Dabei erfassen sie ihre Struktur und Inhalte, sofern durch die robots.txt nicht anders bestimmt. Dabei können Crawler erkennen, ob seit dem letzten Crawl neue Inhalte hinzugekommen sind oder bestehende Inhalte aktualisiert wurden.

Indexierung:

Die Suchmaschinen erhalten die gesammelten Informationen und werten sie aus. Dabei überprüfen sie, welche durch die Crawler gefundenen Inhalte in den Suchmaschinenindex aufgenommen werden (dürfen). Aussortiert werden beispielsweise mit dem noindex-Tag gekennzeichnete Inhalte oder solche, die die Suchmaschine für irrelevant hält.

Ranking:

Alle Seiten, die indexiert werden dürfen, werden Suchanfragen (Keywords) zugeordnet. Die Inhalte der Suchergebnisse werden nach Relevanz absteigend sortiert. Die Seite mit den ‘besten’ Antworten auf eine Suchanfrage wird auf Position 1 der organischen Suchergebnisse platziert.

Suchergebnisse:

Der User stellt eine Suchanfrage. Durch das Ranking ergeben sich die Positionen einzelner Seiten in den organischen Suchergebnisseiten (SERPs), die dem User als Ergebnis angezeigt werden.

Das Crawling ist also die Basis für die Indexierung und im dritten Schritt für das Ranking deiner Inhalte. Zwar beschäftigt sich die Suchmaschinenoptimierung schwerpunktmäßig mit dem Ranking, dennoch solltest du als SEO mit dem Prinzip des Crawlings vertraut sein.

Aus zwei Gründen solltest du Kontrolle über das Crawling deiner Seite übernehmen:

- Schütze Daten, die andere nichts angehen. Überlege dir genau, welche Bereiche oder Inhalte gar nicht erst gecrawlt werden sollen, etwa weil sie Informationen Dritter (Member Areas, Kundenkonten) enthalten. Halte Inhalte aus dem Index, die dort nichts verloren haben.

- Verhindere das unnötige Crawlen von Inhalten, die nicht indexiert werden sollen. Suchmaschinen stellen jeder Website ein tägliches Crawl Budget zur Verfügung. Verschwende es nicht an Seiten, die ohnehin nicht in den Index sollen und sorge dafür, dass es für Seiten genutzt wird, die für deine Rankings wichtig sind.

Lerne auch, wie du richtig mit der robots.txt umgehst, um das Crawling deiner Website gekonnt zu steuern. Und wir beantworten dir außerdem alle Fragen zur Crawl Budget Optimierung.